Unity里贴花的实现方法比较多,商店里的插件也是各种各样,最近正好又在弄这个,趁机会给自己总结下:

1、构造贴片网格

思想很简单,就是在当前表面构建一个与表面完全贴合的新Mesh,并重新计算纹理贴图,从而实现贴片效果。

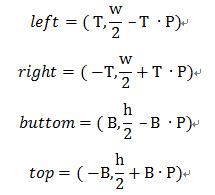

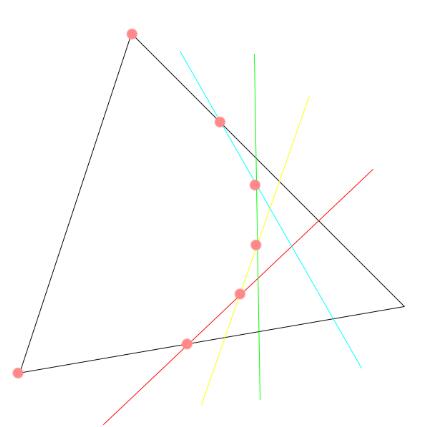

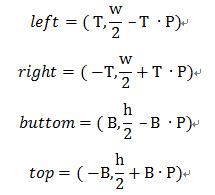

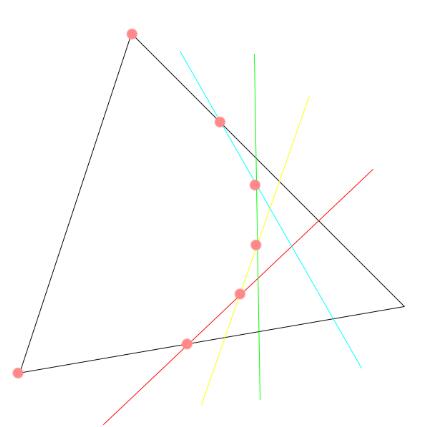

假设 P 为当前表面上的一点, 当前表面在该点的法线为 N, 点 P 为贴片的中心, 贴片的单位切向量为 T

根据给定的点 P , N , T,T 与 N 叉乘可得出的副法线 B, 可以定义表面在点 P 的切平面, 从切平面内可以裁剪出一个矩形, 再加上与法向量 N 平行的4个边平面, 可以构造贴片所在区域。 令 w 和 h 为贴片的宽和高, 则4个边平面的可表示为:

同时,也要进行前后平面的裁剪, 避免那些位于点 P 前后很远但位于边平面内的面被裁剪, 前后平面表示为

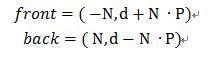

最后可构建出一个裁剪立方体

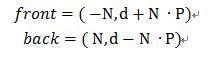

网格构造的执行过程为: 先确定贴片会影响到世界空间中的哪些表面, 可在计算出裁剪立方体后通过 Unity 中Bounds 类自带的 Intersects 函数得到, 对于得到的平面, 逐个遍历其中的三角形。 遍历时, 通过三个点得出三角形的两条边的对应向量, 再通过叉乘得出其法线 M, 转换到同一坐标系后可通过 Vector3.Angle 计算 N 与 M 的夹角, 若夹角大于 90 度, 则表明该三角形为背向贴片, 将其舍弃。 若夹角小于 90 度, 则依次与裁剪立方体的六个面进行比较判断 , 通过 Plane.GetSide 三角形的三角点是在立方体内。 若整个 Mesh 的顶点都在裁剪立方体内, 则将其保存为贴片的 Mesh 顶点, 若没有任何一点在裁剪立方体内, 则将其舍弃, 主要处理的是既有在立方体内的点,又有不在立方体内部的点的情况。

对于贴片可能影响的物体表面, 其中的三角形被当作凸多边形处理, 依次用6个边界平面中的一个屏幕去裁剪。用屏幕裁剪一个有N个顶点的多边形,最多产生一个有 n + 1 个定点的凸多边形, 这样一个三角形被6个平面裁剪, 最多产生有9个顶点的多边形:

如图所示, 截4次,得到7个顶点, 因为 Mesh 中的三角形大部分都会共边,因此每个三角形只裁剪一次。

6个平面裁剪完成后, 最终的凸多边形被当作三角形扇形 (Triangle_fans) 添加到贴片的三角网格。

可通过射线等方式按照其顶点顺序计算出其与立方体表面的一个交点, 并舍弃立方体外的点, 用交点与内部的点重新构建 Mesh, 最后根据新顶点的位置计算其投影后的 UV 坐标即可。

2、G-buffer投影

最早接触到的是 Unity 官方 commandbuffer 例子里的,C#脚本这边很简略,只是在 LightingPass 前 new 了一个commandbuffer, 核心实现则在 Shader 中,vertex 和 fragment shader 代码如下:

struct v2f

{

float4 pos : SV_POSITION;

half2 uv : TEXCOORD0;

float4 screenUV : TEXCOORD1;

float3 ray : TEXCOORD2;

half3 orientation : TEXCOORD3;

};

v2f vert (float3 v : POSITION)

{

v2f o;

o.pos = mul (UNITY_MATRIX_MVP, float4(v,1));

o.uv = v.xz+0.5;

o.screenUV = ComputeScreenPos (o.pos);

o.ray = mul (UNITY_MATRIX_MV, float4(v,1)).xyz * float3(-1,-1,1);

o.orientation = mul ((float3x3)unity_ObjectToWorld, float3(0,1,0));

return o;

}

CBUFFER_START(UnityPerCamera2)

// float4x4 _CameraToWorld;

CBUFFER_END

sampler2D _MainTex;

sampler2D_float _CameraDepthTexture;

sampler2D _NormalsCopy;

fixed4 frag(v2f i) : SV_Target

{

i.ray = i.ray * (_ProjectionParams.z / i.ray.z);

float2 uv = i.screenUV.xy / i.screenUV.w;

// read depth and reconstruct world position

float depth = SAMPLE_DEPTH_TEXTURE(_CameraDepthTexture, uv);

depth = Linear01Depth (depth);

float4 vpos = float4(i.ray * depth,1);

float3 wpos = mul (unity_CameraToWorld, vpos).xyz;

float3 opos = mul (unity_WorldToObject, float4(wpos,1)).xyz;

clip (float3(0.5,0.5,0.5) - abs(opos.xyz));

i.uv = opos.xz+0.5;

half3 normal = tex2D(_NormalsCopy, uv).rgb;

fixed3 wnormal = normal.rgb * 2.0 - 1.0;

clip (dot(wnormal, i.orientation) - 0.3);

fixed4 col = tex2D (_MainTex, i.uv);

if (col.a < 0.8)

col.a = 0;

return col;

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

其中 ray 是相机相机指向每个顶点的向量 (乘以 float3(-1,-1,1) 是因为经过MV变换后 z 通常是负数)

i.ray = i.ray * (_ProjectionParams.z / i.ray.z);

则是将向量的终点由顶点(光栅化后应该是像素,但放这里好像又不太好表达)位置投影到了相机远截面,如图所示:

然后通过深度图得到像素投影在其他物体上的坐标,并重新转换至模型坐标

clip (float3(0.5,0.5,0.5) - abs(opos.xyz));

因为 Demo 中使用的是单位大小的 Cube, 因此投影后在 Cube 外的像素直接 clip 掉

clip (dot(wnormal, i.orientation) - 0.3);

则是将投影点的法线与设施好的 Decal 朝向做比较,裁剪掉角度太大的避免贴图拉伸造成的Artificial, 如图所示:

也不能说好还是不好23333

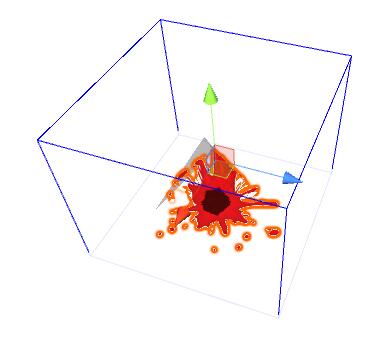

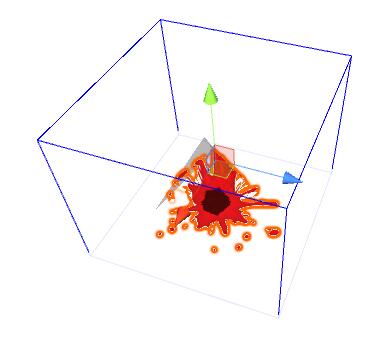

3、Forward Render 投影

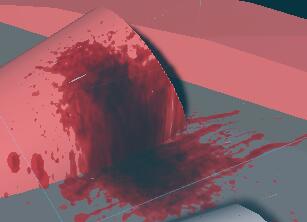

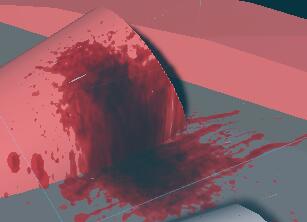

思路基本上跟G-BUFFER的一样,既然延迟渲染可以这样做,Forward为什么不行,同样有 NormalDepthTexture,如法炮制,我们得到这样的结果:

很明显,深度图精度不够,导致渲染结果惨不忍睹,其原因是在 forward path 下相机渲染 DepthNormals texture 时, depth 和 normal 各分配了两个 8 bits 的通道, 而单独只渲染 depth 的时候会根据配置给 16 或者 32 bits。因此,我们可以通过 replacement shader 和 command buffer 自己提前渲染好高精度的深度图,结果就好很多了:

4、others

projector就不说啦,适合用于数量多的血迹或者弹孔,之前看到寒霜引擎有篇演讲是用 geometry shader 去做弹痕的 decal,但一时半会儿找不到链接了,之后再补吧

|